Microsoft kaufte in diesem Jahr doppelt so viele der Flaggschiff-Chips von Nvidia wie jeder seiner größten Konkurrenten in den USA und China, da der größte Investor von OpenAI seine Investitionen in die Infrastruktur für künstliche Intelligenz beschleunigte.

Analysten des Technologieberatungsunternehmens Omdia schätzen, dass Microsoft in diesem Jahr 485.000 „Hopper“-Chips von Nvidia gekauft hat. Damit lag Microsoft weit vor Nvidias zweitgrößtem US-Kunden Meta, der 224.000 Hopper-Chips kaufte, sowie vor seinen Cloud-Computing-Konkurrenten Amazon und Google.

Da die Nachfrage in den letzten zwei Jahren das Angebot an Nvidias fortschrittlichsten Grafikprozessoren größtenteils überstieg, hat Microsoft mit seinem Chipvorrat einen Vorsprung im Wettlauf um die Entwicklung der nächsten Generation von KI-Systemen verschafft.

In diesem Jahr haben große Technologieunternehmen Dutzende Milliarden Dollar für Rechenzentren ausgegeben, in denen die neuesten Chips von Nvidia laufen. Diese sind zum heißesten Gut im Silicon Valley geworden, seit das Debüt von ChatGPT vor zwei Jahren einen beispiellosen Anstieg der Investitionen in KI auslöste.

Die Azure-Cloud-Infrastruktur von Microsoft wurde verwendet, um das neueste o1-Modell von OpenAI zu trainieren, während sie gegen ein wiederauflebendes Google, Start-ups wie Anthropic und Elon Musks xAI sowie Konkurrenten in China um die Vorherrschaft in der nächsten Computergeneration antreten.

Omdia schätzt, dass ByteDance und Tencent in diesem Jahr jeweils etwa 230.000 Chips von Nvidia bestellt haben, darunter das H20-Modell, eine weniger leistungsstarke Version von Hopper, die modifiziert wurde, um den US-Exportkontrollen für chinesische Kunden zu entsprechen.

Amazon und Google, die zusammen mit Meta den Einsatz ihrer eigenen benutzerdefinierten KI-Chips als Alternative zu den von Nvidia verstärken, kauften 196.000 bzw. 169.000 Hopper-Chips, sagten die Analysten.

Omdia analysiert zur Berechnung seiner Schätzungen die öffentlich bekannt gegebenen Investitionsausgaben, Serverlieferungen und Lieferketteninformationen von Unternehmen.

Der Wert von Nvidia, das nun mit der Einführung des Hopper-Nachfolgers Blackwell beginnt, ist in diesem Jahr auf über 3 Billionen US-Dollar gestiegen, da große Technologieunternehmen sich beeilen, immer größere Cluster seiner GPUs zusammenzustellen.

Allerdings hat der außergewöhnliche Anstieg der Aktie in den letzten Monaten nachgelassen, da Bedenken hinsichtlich eines langsameren Wachstums, der Konkurrenz durch die eigenen KI-Chips der Big-Tech-Unternehmen und einer möglichen Beeinträchtigung ihrer Geschäfte in China durch die neue Regierung von Donald Trump in den USA bestehen.

ByteDance und Tencent haben sich in diesem Jahr zu zwei der größten Kunden von Nvidia entwickelt, obwohl die US-Regierung die Fähigkeiten amerikanischer KI-Chips, die in China verkauft werden dürfen, einschränkt.

Microsoft, das 13 Milliarden US-Dollar in OpenAI investiert hat, war das aggressivste US-amerikanische Big-Tech-Unternehmen beim Aufbau der Rechenzentrumsinfrastruktur, sowohl um seine eigenen KI-Dienste wie seinen Copilot-Assistenten zu betreiben als auch um es über seine Azure-Abteilung an Kunden zu vermieten .

Die Bestellungen von Microsofts Nvidia-Chips sind mehr als dreimal so hoch wie die Anzahl der AI-Prozessoren derselben Generation von Nvidia, die das Unternehmen im Jahr 2023 gekauft hat, als Nvidia nach dem bahnbrechenden Erfolg von ChatGPT mit der Ausweitung der Hopper-Produktion kämpfte.

„Gute Rechenzentrumsinfrastruktur, es handelt sich um sehr komplexe, kapitalintensive Projekte“, sagte Alistair Speirs, Senior Director Azure Global Infrastructure bei Microsoft, gegenüber der Financial Times. „Sie erfordern eine mehrjährige Planung. Daher ist es wichtig, vorherzusagen, wo unser Wachstum mit etwas Puffer liegen wird.“

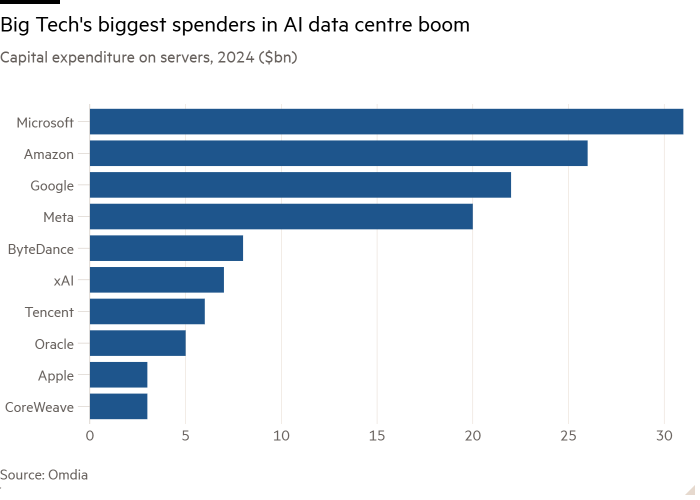

Laut Omdia werden Technologieunternehmen auf der ganzen Welt im Jahr 2024 schätzungsweise 229 Milliarden US-Dollar für Server ausgeben, angeführt von Microsoft mit 31 Milliarden US-Dollar und Amazon mit 26 Milliarden US-Dollar. Die Top-10-Käufer von Rechenzentrumsinfrastruktur – zu denen mittlerweile die relativen Newcomer xAI und CoreWeave gehören – machen 60 Prozent der weltweiten Investitionen in Rechenleistung aus.

Vlad Galabov, Direktor für Cloud- und Rechenzentrumsforschung bei Omdia, sagte, dass im Jahr 2024 etwa 43 Prozent der Ausgaben für Server an Nvidia gingen.

„Nvidia-GPUs machten einen enorm hohen Anteil an den Serverinvestitionen aus“, sagte er. „Wir sind nah am Gipfel.“

Während Nvidia immer noch den Markt für KI-Chips dominiert, ist sein Silicon-Valley-Rivale AMD auf dem Vormarsch. Laut Omdia kaufte Meta in diesem Jahr 173.000 der MI300-Chips von AMD, während Microsoft 96.000 kaufte.

Große Technologieunternehmen haben in diesem Jahr auch die Nutzung ihrer eigenen KI-Chips verstärkt, um ihre Abhängigkeit von Nvidia zu verringern. Google, das seit einem Jahrzehnt seine „Tensor Processing Units“ oder TPUs entwickelt, und Meta, das letztes Jahr die erste Generation seines Meta Training and Inference Accelerator-Chips vorstellte, setzten jeweils etwa 1,5 Millionen eigene Chips ein.

Amazon, das stark in seine Trainium- und Inferentia-Chips für Cloud-Computing-Kunden investiert, hat in diesem Jahr etwa 1,3 Millionen dieser Chips eingesetzt. Amazon gab diesen Monat bekannt, dass es den Aufbau eines neuen Clusters mit Hunderttausenden seiner neuesten Trainium-Chips für Anthropic, einen OpenAI-Konkurrenten, in den Amazon 8 Milliarden US-Dollar investiert hat, plant, um die nächste Generation seiner KI-Modelle zu trainieren.

Allerdings ist Microsoft mit seinen Bemühungen, einen KI-Beschleuniger zu entwickeln, der mit dem von Nvidia konkurrieren kann, schon viel früher dran, da in diesem Jahr erst etwa 200.000 seiner Maia-Chips installiert wurden.

Speirs sagte, dass die Nutzung der Nvidia-Chips von Microsoft immer noch erhebliche Investitionen in die eigene Technologie erfordern würde, um den Kunden einen „einzigartigen“ Service bieten zu können.

„Um die KI-Infrastruktur aufzubauen, kommt es unserer Erfahrung nach nicht nur darauf an, den besten Chip zu haben, sondern auch auf die richtigen Speicherkomponenten, die richtige Infrastruktur, die richtige Softwareschicht, die richtige Host-Management-Schicht, Fehlerkorrektur und all das andere Komponenten zum Aufbau dieses Systems“, sagte er.